Sự phát triển mạnh mẽ của trí tuệ nhân tạo trong vài năm gần đây mở ra hàng loạt tiện ích cho đời sống, công việc và giải trí. Tuy nhiên, đi kèm với đó là những rủi ro tiềm ẩn về an toàn dữ liệu mà phần lớn người dùng không hề nhận ra. Khi AI len lỏi vào mọi hoạt động online — từ làm việc, học tập đến giải trí — dữ liệu cá nhân đang bị thu thập, khai thác và lạm dụng với tốc độ chưa từng có.

Dưới đây là những nguyên nhân chính khiến AI trở thành “chất xúc tác” làm tăng nguy cơ rò rỉ dữ liệu cá nhân:

Kĩ thuật tấn công dựa trên AI ngày càng tinh vi

Sự bùng nổ của AI cũng kéo theo mức độ nguy hiểm của tội phạm mạng khi những công cụ tiên tiến này đang được “vũ khí hóa” phục vụ cho những mục đích phạm tội:

Các báo cáo từ Trend Micro và IBM Security cho thấy AI đã giúp tin tặc rút ngắn 70% thời gian tấn công và tăng độ chính xác trong việc dự đoán mục tiêu.

Lạm dụng các ứng dụng AI giải trí và vô tình cung cấp dữ liệu sinh trắc học

Các trend “tạo ảnh, tạo video bằng AI” — như hiệu ứng tuyết mùa đông, biến đổi gương mặt, giả lập chân dung cổ điển, hay ghép mặt vào người nổi tiếng — đang thu hút hàng triệu người tham gia.

Nhưng đằng sau vài thao tác vui vẻ lại là việc người dùng tự tay cung cấp dữ liệu sinh trắc học gồm:

Dữ liệu khuôn mặt là loại dữ liệu không thể thay đổi được — bị lộ một lần là mất quyền kiểm soát vĩnh viễn. Và khi vào tay tội phạm mạng, nó có thể bị sử dụng để tạo deepfake, mở khóa sinh trắc học, hay mạo danh trong các giao dịch tài chính.

Với sự phát triển của AI hiện nay, khi dữ liệu khuôn mặt bị thu thập tràn lan, tội phạm hoàn toàn có thể:

Thời gian tạo deepfake giờ chỉ cần vài giây nhờ mô hình AI thế hệ mới.

Phụ thuộc vào chatbot AI và vô tình tiết lộ quá nhiều thông tin

Khác với các công cụ tìm kiếm truyền thống (như Google Search), các mô hình ngôn ngữ lớn (LLM) và ứng dụng AI thường hoạt động theo cơ chế: Thu thập dữ liệu đầu vào để huấn luyện ngược lại cho hệ thống.

Trong công việc và học tập, nhiều người đang dần quen với việc:

vào các chatbot như ChatGPT, Claude, Gemini hay trợ lý AI trong ứng dụng văn phòng.

Vấn đề nằm ở chỗ:

Các báo cáo an ninh mạng gần đây của Cloudflare, Kaspersky, Microsoft… cũng chỉ ra sự gia tăng mạnh của các vụ rò rỉ dữ liệu nội bộ bắt nguồn từ chính nhân viên đưa tài liệu lên chatbot AI mà không được phép.

AI thu thập dữ liệu vượt ngoài khả năng kiểm soát của người dùng

Thực tế, dữ liệu cá nhân không chỉ bị thu thập bởi những gì người dùng chủ động cung cấp, mà còn bởi vô số hệ thống, thiết bị và ứng dụng sử dụng thuật toán học máy hoạt động âm thầm phía sau. Điều này tạo ra một môi trường mà người dùng gần như không thể kiểm soát hoàn toàn phạm vi dữ liệu bị thu thập.

Hiện nay, AI hiện diện ở khắp nơi từ trình duyệt, điện thoại, TV thông minh, camera an ninh, thiết bị IoT trong nhà, cho đến xe hơi — hầu hết đều sử dụng AI hoặc machine learning để:

- ghi nhận hành vi và thói quen sử dụng,

- theo dõi lịch sử tìm kiếm và duyệt web,

- phân tích giọng nói thông qua micro,

- đọc nội dung hiển thị trên màn hình,

- xác định vị trí và dịch chuyển,

- tối ưu hóa trải nghiệm cá nhân dựa trên dữ liệu tích lũy.

Sự “hiện diện mọi nơi” này đồng nghĩa với việc người dùng khó biết được cụ thể thiết bị nào đang thu thập dữ liệu gì, thu thập vào thời điểm nào, và được sử dụng với mục đích ra sao.

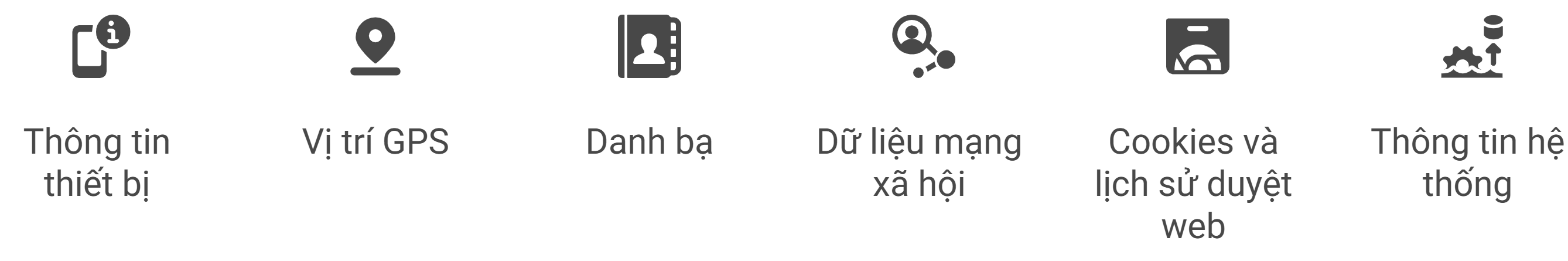

Nhiều công cụ AI, đặc biệt là ứng dụng di động, không chỉ thu thập dữ liệu mà người dùng tải lên (ảnh, giọng nói, văn bản) mà còn lấy:

- thông tin thiết bị,

- vị trí GPS,

- danh bạ,

- dữ liệu mạng xã hội liên kết,

- cookies và lịch sử duyệt web,

- thông tin hệ thống và hoạt động trong nền.

AI càng tiện lợi, người dùng càng ít để ý đến quyền truy cập. Chỉ cần một lần cho phép truy cập camera, cấp quyền đọc thư viện ảnh, kết nối với tài khoản Google/Facebook, là ứng dụng có thể lấy đi lượng dữ liệu lớn không thể thu hồi. Tất cả những gì chúng thu thập được sẽ được tổng hợp thành “hồ sơ người dùng” chi tiết — một điểm dữ liệu cực kỳ giá trị cho tội phạm công nghệ cao.

Người dùng ngày càng mù mờ về dữ liệu của chính mình. Nhưng vấn đề lớn nhất nằm ở:

Kết quả: AI biết nhiều hơn về người dùng so với chính họ, từ mức độ thân mật trong các mối quan hệ đến thói quen tiêu tiền.

Điều này mở ra nguy cơ nghiêm trọng: khi dữ liệu bị rò rỉ hoặc bán cho bên thứ ba, tội phạm mạng có thể dùng “hồ sơ AI” này để cá nhân hóa lừa đảo, tấn công nhắm mục tiêu, và tạo ra các kịch bản giả mạo cực kỳ thuyết phục.

Vậy làm sao để bảo vệ dữ liệu cá nhân trong thời đại AI bùng nổ này?